自律型致死兵器システム(LAWS)に関する各国の立ち位置

国際紛争の高まりを追い風に、AI搭載の兵器への投資が勢いを増している。欧米ではAI防衛業界の新興企業が多額の出資を獲得するなど注目を集めている。その一方、国連軍縮部における自律型致死兵器システム(LAWS)の扱いをめぐる議論は遅々とした歩みである。

背景/国連

国連のアントニオ・グテーレス事務総長は2018年、LAWSについて“道徳的に反吐が出る” と表現し、その禁止を初めて呼びかけた。国連では100カ国以上がLAWSを禁止・制限するための新たな国際法の交渉や採択に関心を示している。

グテーレス氏は2026年までにLAWSを禁止する法的拘束力のある枠組みを採択するよう、国連加盟国に求めたものの、2023年末の会合ではロシアなど4カ国が反対し、中国やイスラエルなど11カ国が棄権した[1]。

国連の特定通常兵器使用禁止制限条約(CCW)[2]会合はこれまでも2022年の禁止を求める強力なマンデートを目指したが、圧倒的な支持にもかかわらず、イスラエル、ロシア、英国、米国などの少数国が反対したため、LAWSについては「提案を検討し、コンセンサスによって可能な措置を練り上げる」という尻すぼみの結果に至った経緯がある。現在はこれに続く協議が行われている。

日本の立場

わが国では、政府の基本的な立場は外務省発表の「自律型致死兵器システム(LAWS)について[3]」(令和6年6月24日)で示されている。これは、CCWのもとにおける議論の過程で、日本が提出した作業文書(2024年5月)の中で、述べられている「我が国の基本的な立場」である。

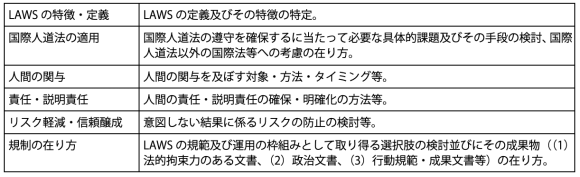

国連が提示した論点は以下であった。

これについての政府発表は、

- 我が国は、人間の関与が及ばない完全自律型の致死性兵器の開発を行う意図はなく、また、当然のことながら国際法や国内法により使用が認められない装備品の研究開発を行うことはありません。

- 新興技術の軍事利用については、そのリスクとメリットを十分理解し、人道的考慮と安全保障上の観点を踏まえながら、包括的な検討を行う必要があります。包括的検討に当たり、我が国は、新興技術の軍事利用は、人間中心の原則を維持し、信頼性、予見可能性を確保し、責任ある形で行われることを重視しています。また、国際人道法(IHL)[4]の義務はLAWSを含む全ての兵器システムに適用されるものであり、IHLを遵守する形で使用できない兵器システムは使用してはならず、それ以外の兵器システムについても、IHLの遵守を確保するために必要な制限を行うとの考え方を支持しています。

- 一方で、人間の関与が確保された自律性を有する兵器システムは、ヒューマンエラーの減少、省力化・省人化といった安全保障上の意義を有するとの考えです。

- 新興技術の更なる発展を見据え、IHL等の国際法との関係を整理しつつ、LAWSに係る規範・運用の枠組みの明確化に向けて取り組むことは重要です。今後も、我が国は、LAWSに係る国際的なルール作りを通じて国際社会の安定に貢献すべく、主要国を含め、広く国際社会において共通の認識が得られるよう、国際的なルール作りに積極的かつ建設的に参加していく考えです。

(下線引用者)

本文では「責任ある」はaccountability, responsibility との表現で現れ、一般的には「説明責任」で代表される概念と思われる。

米国

LAWSについての政治宣言

LAWSに関する米国政府の立場としては国務省の発表、「AIと自律化技術の責任ある軍事利用に関する政治宣言(Political Declaration on Responsible Military Use of Artificial Intelligence and Autonomy)[5]」があり、米国はこの宣言に2024年5月19日時点で54カ国の賛同があったことを明らかにしている[6]。

宣言は、各国とも1)AI機能の責任ある開発、展開、使用を行い、2)軍事AI能力が国際法、特に国際人道法に基づくそれぞれの義務に従って使用されるよう、法的審査などの適切な措置を講じるべきであるとするほか、兵器機能の監督、使用における適切な注意、機能の透明性・監査システムの完備、用途の明確性、ライフサイクルを通じたテストと保証、フェールセーフなど安全策の実施といった兵器の運用にわたったルールを列挙している。

これは米国提案による政治宣言で、人工知能(AI)を活用した兵器などの軍事システムの開発と試験、検証に関する新たなビジョンを打ち出したもので、近年急速に進展する軍事AIの開発に関する米国の試みである。同文書は米軍を法的に拘束するものではないが、同盟国がその原則に同意し、責任をもってAIシステムを構築するための国際基準を生み出すことを期待しており、次の目標を挙げている[7]。

- 武力紛争におけるAIの使用は、国際人道法の基本原則を含む国際人道法に基づく国家の義務に従わなければならない。

- AI機能の軍事利用は、責任ある人間の指揮統制系統内での軍事作戦中の使用を含め、説明責任を果たす必要がある。

- AIの軍事利用に対する原則的なアプローチには、リスクと利点の慎重な考慮が含まれるべきであり、意図しない偏見や事故を最小限に抑える。

- 軍事用AI機能の責任ある開発、展開、使用を確保するために適切な措置を講じる。これらの措置は、軍事用AI機能のライフサイクル全体の関連する段階で実装する。

また、宣言目標を推進するために、支持国に対し、宣言へのコミットメントを公表し、これらの措置の実施に関する適切な情報を公開し、また支持国間で継続的な議論を追及することを促している。

軍におけるLAWSの現状

米国は現在、LAWSを保有していないとされている。しかし、LAWS の開発、実戦配備、使用を禁止してもいない。また、LAWSを禁止する立場はとっていない。2023年のAI安全性に関する大統領令でも軍事技術は除外されている。議会がこれまでにAI技術に関するアクションをとったことはない。以下は米国議会のレポート[8]から得られたLAWSに関する情報である。

LAWSの定義

国防省のDepartment of Defense Directive (DODD) 3000.09は、LAWSの定義を「目標を独自に識別し、搭載された兵器を使用して、人間の手動操作なしに目標と交戦・破壊することができる兵器システム。」と定義している。これは“human out of the loop” もしくは “full autonomy”と表現される。

これと対比される兵器システムに、半自律型の「人間のオペレーターによって選択された個々の標的または特定の標的グループにのみ対処する」兵器システムがある(この兵器は半自律型LAWSと文書中に現れる)。これは“human in the loop”と表現される。

ガイドライン

上記のDODD 3000.09 は、LAWS の将来の開発と実戦配備に向けて、 LAWS が「戦争法、適用される条約、兵器システム安全規則、および適用される交戦規則」を遵守することを確実にするよう、DOD ガイドラインを定めている。ガイドラインはLAWSを含むすべてのシステムが、

「指揮官とオペレーターが武力行使に関して適切なレベルの人間としての判断を行えるよう設計されていること(designed to “allow commanders and operators to exercise appropriate levels of human judgment over the use of force”.)」

を義務付けている。「適切な」は融通の利く言葉であって、特定の尺度を表さず、どのような状況でもそれに応じた評価を可能にする。兵器システムの性質や交戦領域などに応じて適切性の内容は異なってくる。

ここで「武器使用に関する人間としての判断」とは、武器システムを人間が手動で「制御」することではない。武器を使用するかについての意思決定、つまり、武器をどのように、いつ、どこで、なぜ使用するかという決定に、人間がより広く関与するべきという意味である。この意思決定において、兵器は「適切な注意を払い、戦争法、適用される条約、兵器システムの安全規則、適用される交戦規則に従って」使用されるべきとされ、適法性への配慮が重要になる。そのために、現実的な実践状況に臨み、使い手(指揮官、オペレーター)の十分な訓練と、定期的な武器の審査が必要となる。

さらに、LAWSを含むすべてのシステムのソフトウェア、ハードウェアの試験・評価において以下の機能が確実に備わっていることが求められる。

- 現実的な作戦環境において、適応力のある敵に対して予想される機能を発揮する

- 指揮官とオペレーターの意図に沿った時間枠で交戦を完了できない場合は、交戦を終了するか、交戦を継続する前にオペレーターの追加投入を求める

- 意図しない交戦への発展、あるいは権限のない第三者にシステム制御がわたることによる障害を最小限に抑える堅牢さを備える

上述の政治宣言には、国防省のガイドラインの考え方が反映されていることがわかるが、いずれについても完全自律型兵器(国防省が定義したLAWS)に特定したルールではない。

米国による国連提出意見[9]は、上の2文書の内容を統合したものとなっている。

英国

英国は日本と同様、国連に同国の立場を表した作業文書[10]を提出している。以下がそのサマリーである。

- 英国は完全な自律型兵器システム、つまり人間の適切な関与なしに、あるいは人間の責任や説明責任の範囲外で作動する兵器を保有しておらず、開発する意図もない。

- 国際人道法(IHL)と、兵器システムの開発、調達、使用に関する既存の規制枠組みが、新たな軍事能力を規制するための適切な枠組みである。

- 自律兵器システムの開発と使用すべてにわたり、人間の判断が常に必要となる。

- システムの自律性のレベルやAIのような実現技術の使用に関係なく、ある効果を達成するためのシステムの使用に対する人間の責任を取り除くことはできない。

- 自律型兵器システムの責任ある開発と使用のための規範と基準を開発するために国際的に取り組むことは、これらの技術の違法で、安全でない、または非倫理的な使用を識別し、原因と特定し、責任者に責任を負わせることを確実にする最善の方法である。

英国は国際人道法と既存の規制枠組みに基づいて、適切な枠組みを構築する意欲を見せているが、積極的なLAWS禁止ルールを求めてはいない。兵器開発、運用の現場における人間の関与と、規範と基準を開発するための国際的な取り組みと、枠組み形成に意欲を見せている。

特に、現行国際法では戦争結果の説明責任/(結果への)を機械に負わせることができない点が課題であるとして、LAWSのライフサイクル全般にわたる評価システムの構築を提案している。兵器の運用局面においては、状況に応じた人間の介入という視点で評価するべきとの立場を打ち出している。

「英国は、上記のような状況に応じて適切なレベルの人間の関与と説明責任なしに運用される自律機能を備えた兵器の創設と使用に反対する。私たちは、他の関係者の立場や態度が不確かであることを認識し、すべての国家が自律システムを含む軍事AIの責任ある開発と使用に明確なコミットメントを行うべきであり、これらの技術の違法で、安全でない、または非倫理的な使用を識別し、原因と特定し、責任者に責任を負わせることを保証すべきであると考える。(下線引用者)」

国家が責任を負うべきとの立場を明確に表現した一節となっている。

IHLに従ったLAWSの規制案

実は上の3カ国は、豪州、カナダ、韓国、と連名でLAWSに関する規制案[11]を国連に提出している。各国が今回国連に提出した意見はその関係国間の合意を反映しており、基本的考え方に大きな相違点はないと考えられる。

共通する論理は以下である。IHLの原則はいかなる兵器使用に関しても守らなければならない。IHLの下での責任とは人(国家含む)が負うべきものであり、LAWSの使用結果についての説明責任/責任は人が負うべきである。IHLは自律兵器システムを禁じておらず、機械に責任を負わせることはできないのである。米国はこれに関連して、LAWSに定義を与えることについても極めて慎重である。

一方、日英は完全自律型兵器について、これの開発、使用を行わず、今後も行う意思がないことを明言し、すべての国がこれに倣うべきと考えている。もっともこの意思とは、英国の場合、提案中の規制を適用できれば将来的に開発を許容するものなのかもしれない。3国とも拘束力あるルールの採用には否定的である。

LAWSの開発、使用における「適切なレベルの人間としての判断」という米軍用語は、日本ではそのまま採用され、英国では「状況に応じた適切な」という用語になって反映されている。さらに、英国は判断に対する評価に「倫理」を入れようとする動きを見せている。

日本、米国、英国、カナダの4カ国はAI安全性に取り組む機関の設立に動いており、米国は最近、AI Safety and Security Boardを国土安全保障省に立ち上げたところだ。とはいえ、安全性を論じるべきこれらの機関はどれもAIの軍事利用のガバナンスを扱っていない。EUのAI法もしかりである。紛争の高まりの状況の中でこれは驚くべきといえる[12]。

日本は国際ルールの形成に携わる意欲を見せているが、類似の意欲を見せている英国のような国との連携は1つの方向性となるのだろう。ルールを形成したとしても、LAWSの開発を進める米国を含む武器大国を止めることは限りなく難しい。悪化する人道危機を眼前に、「人間としての判断」にせめて倫理の基準が含まれることを願うばかりである。

[1] https://www3.nhk.or.jp/news/html/20240305/k10014379161000.html https://www.nikkei.com/article/DGXZQOUA274230X20C24A6000000/

[2] 特定通常兵器使用禁止制限条約(CCW)https://www.hrw.org/report/2022/11/10/agenda-action/ alternative-processes-negotiating-killer-robots-treaty

[3] https://www.mofa.go.jp/mofaj/dns/ca/page24_001191.html

[4] 国際人道法には、紛争当事者が用いることのできる戦闘の手段と方法(兵器とその使用法)を制約する一般原則が存在する。

①軍事的必要性と人道的配慮のバランスをとること、

②軍事目標と文民を区別し、軍事目標のみに攻撃を行うこと(区別原則)、

③攻撃によって発生する軍事的利益と付随的被害(文民への被害)のバランスをとること(均衡原則)、

④無差別攻撃を行わないこと、⑤付随的被害を低下させるための各種の予防措置を実施すること

[5] https://www.state.gov/political-declaration-on-responsible-military-use-of-artificial-intelligence-and-autonomy-2/

[6] https://www.state.gov/political-declaration-on-responsible-military-use-of-artificial-intelligence-and-autonomy/

[7] https://www.state.gov/political-declaration-on-responsible-military-use-of-artificial-intelligence-and-autonomy-2/

[8] https://crsreports.congress.gov/product/pdf/IF/IF11150

[9] https://docs-library.unoda.org/General_Assembly_First_Committee_-Seventy-Ninth_session_(2024)/78-241-US-EN.pdf

[10] https://docs-library.unoda.org/General_Assembly_First_Committee_-Seventy-Ninth_session_(2024)/78-241-UK-EN.pdf

[11] Draft Articles on Autonomous Weapon Systems – Prohibitions and Other Regulatory Measures on the Basis of International Humanitarian Law (“IHL”), CCW/GGE.1/2023/WP.4/Rev.2,

https://docs-library.unoda.org/Convention_on_Certain_Conventional_Weapons_-Group_of_Governmental_ Experts_on_Lethal_Autonomous_Weapons_Systems_(2023)/CCW_GGE1_2023_WP.4_US_Rev2.pdf

[12] https://www.ft.com/content/da03f8e1-0ae4-452d-acd1-ec284b6acd78

※この記事は会員サービス「InfoCom T&S」より一部抜粋して公開しているものです。

当サイト内に掲載されたすべての内容について、無断転載、複製、複写、盗用を禁じます。InfoComニューズレターを他サイト等でご紹介いただく場合は、あらかじめ編集室へご連絡ください。また、引用される場合は必ず出所の明示をお願いいたします。

調査研究、委託調査等に関するご相談やICRのサービスに関するご質問などお気軽にお問い合わせください。

ICTに関わる調査研究のご依頼はこちら関連キーワード

八田 恵子の記事

関連記事

-

デジタル技術を活用したウェルビーイング(Well-being)の向上

- WTR No441(2026年1月号)

- ヘルスケア・医療

- 日本

-

世界の街角から:豪州 ウルル・シドニー ~大自然と歴史を感じる

- WTR No441(2026年1月号)

- オーストラリア

- 世界の街角から

-

通信事業者は6Gをスマートパイプへのチャンスに

- 5G/6G

- AI・人工知能

- ICR Insight

- WTR No441(2026年1月号)

- モバイル通信事業者(国内)

- モバイル通信事業者(海外)

-

中国におけるロボット産業の進展

- WTR No441(2026年1月号)

- ロボット

- 中国

-

ポイント経済圏事業者の2026年戦略アジェンダ 〜消費者の利用実態調査より〜

- WTR No441(2026年1月号)

- ポイントビジネス

- 日本

- 経済

- 金融

InfoCom T&S World Trend Report 年月別レポート一覧

ランキング

- 最新

- 週間

- 月間

- 総合